Black Box IA : Défis et solutions pour une intelligence artificielle transparente

L’intelligence artificielle (IA) modernise de nombreux secteurs, mais son opacité soulève des interrogations légitimes. Le concept de black box IA cristallise ces préoccupations, mettant en lumière les défis liés à la compréhension et à l’explication des décisions algorithmiques complexes. Dans ce billet, nous analyserons les enjeux de la black box IA, les solutions émergentes pour une intelligence artificielle transparente, et les perspectives d’avenir dans ce domaine en constante évolution.

- La black box IA pose des problèmes de confiance et d’éthique

- L’explicabilité est cruciale pour l’adoption et la conformité réglementaire

- Des techniques comme LIME et SHAP permettent d’interpréter les décisions des modèles

- La recherche se poursuit pour développer des méthodes d’explicabilité plus performantes

- L’équilibre entre performance et transparence reste un défi majeur

Les défis de l’IA boîte noire : opacité et manque de transparence

L’IA boîte noire désigne les systèmes d’intelligence artificielle dont le fonctionnement interne est difficile, voire impossible, à interpréter pour les humains. Cette opacité est particulièrement prégnante dans les modèles de deep learning, où des millions de paramètres interagissent de manière complexe pour produire des résultats. Nous sommes confrontés à un paradoxe : plus les algorithmes deviennent performants, moins nous comprenons leur processus décisionnel.

Cette situation soulève de sérieuses questions en termes de confiance, d’éthique et de responsabilité. Comment pouvons-nous faire confiance à un système dont nous ne comprenons pas le raisonnement ? Comment garantir l’équité et éviter les biais si nous ne pouvons pas examiner le processus décisionnel ? Ces interrogations prennent une dimension critique dans des domaines sensibles tels que la santé, la justice ou la finance.

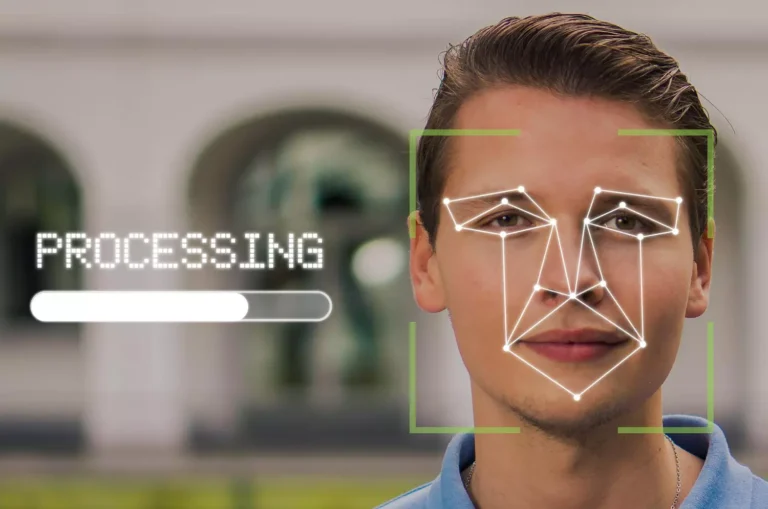

Prenons l’exemple d’un système d’IA utilisé pour évaluer les demandes de prêt bancaire. Si le modèle rejette systématiquement les demandes de certains groupes démographiques sans explication claire, cela peut conduire à des discriminations involontaires et illégales. L’opacité du système empêche alors toute possibilité de correction ou d’amélioration.

L’importance de l’explicabilité dans les systèmes d’IA

Face à ces défis, l’IA explicable (XAI) émerge comme une solution prometteuse. Son objectif est de rendre les décisions des algorithmes d’IA plus compréhensibles et interprétables pour les humains. L’explicabilité ne se limite pas à une simple transparence technique ; elle vise à fournir des explications significatives et accessibles aux utilisateurs finaux, qu’ils soient experts ou novices.

L’importance de l’explicabilité va au-delà de la simple satisfaction de la curiosité intellectuelle. Elle est cruciale pour l’adoption et la confiance dans l’IA. En 2023, une étude de Gartner a révélé que 84% des entreprises considèrent l’explicabilité comme un facteur clé dans leur décision d’adopter des solutions d’IA. Nous constatons que la capacité à comprendre et à justifier les décisions algorithmiques devient un avantage compétitif majeur.

L’IA explicable joue également un rôle essentiel dans la détection et la correction des biais. Elle permet d’identifier les facteurs influençant une décision spécifique, offrant en conséquence la possibilité de corriger les préjugés potentiels intégrés dans les données d’entraînement ou les algorithmes eux-mêmes. Cette approche favorise une IA plus équitable et éthique, alignée sur les valeurs humaines et les principes de non-discrimination.

Techniques et approches pour rendre l’IA plus transparente

Pour relever le défi de l’explicabilité, diverses techniques et approches ont été développées. Nous distinguons deux grandes catégories : les modèles intrinsèquement interprétables et les techniques d’explication a posteriori.

Les modèles intrinsèquement interprétables, comme les arbres de décision ou les règles d’association, offrent une transparence native. Leur structure permet de comprendre facilement le cheminement logique menant à une décision. D’un autre côté, ces modèles peuvent parfois sacrifier la performance au profit de la simplicité.

Les techniques d’explication a posteriori, quant à elles, visent à interpréter les décisions des modèles complexes après leur exécution. Parmi les méthodes les plus populaires, nous trouvons :

- LIME (Local Interpretable Model-agnostic Explanations) : Cette technique crée un modèle simplifié autour d’une prédiction spécifique pour expliquer son raisonnement.

- SHAP (SHapley Additive exPlanations) : Basée sur la théorie des jeux, elle attribue une importance à chaque caractéristique pour une prédiction donnée.

- Grad-CAM : Cette méthode de visualisation permet d’identifier les régions d’une image qui ont le plus influencé la décision d’un réseau de neurones convolutif.

Ces techniques offrent des perspectives précieuses sur le fonctionnement interne des modèles complexes, facilitant donc leur interprétation et leur validation.

Enjeux réglementaires et éthiques de l’IA explicable

L’explicabilité de l’IA n’est pas qu’une question technique ; elle revêt une importance croissante sur le plan réglementaire et éthique. Nous assistons à une prise de conscience globale des enjeux liés à l’utilisation de l’IA, conduisant à l’émergence de nouvelles réglementations.

Le Règlement Général sur la Protection des Données (RGPD) en Europe, par exemple, inclut un « droit à l’explication » pour les décisions automatisées affectant les individus. Aux États-Unis, des initiatives similaires sont en cours, comme le projet de loi sur l’IA responsable (Algorithmic Accountability Act). Ces réglementations soulignent l’importance de pouvoir expliquer et justifier les décisions prises par les systèmes d’IA.

La certification des algorithmes d’IA est également envisagée, notamment pour les applications à fort impact. Cette approche viserait à garantir un niveau minimal de transparence et de robustesse des systèmes d’IA avant leur déploiement dans des domaines critiques.

L’IA explicable joue un rôle central dans la gouvernance algorithmique et l’utilisation éthique de l’IA. Elle permet de :

| Aspect | Contribution de l’IA explicable |

|---|---|

| Responsabilité | Facilite l’attribution de responsabilité en cas de décision erronée |

| Transparence | Permet aux parties prenantes de comprendre et d’auditer les décisions |

| Équité | Aide à identifier et corriger les biais potentiels |

| Confiance | Renforce la confiance des utilisateurs et du public envers l’IA |

Perspectives d’avenir et défis persistants de l’IA explicable

Malgré les progrès significatifs réalisés dans le domaine de l’IA explicable, des défis importants persistent. L’explicabilité reste particulièrement complexe pour les systèmes d’IA très avancés, comme les grands modèles de langage ou les réseaux de neurones profonds multicouches.

Nous sommes confrontés à un dilemme constant entre performance et explicabilité. Les modèles les plus performants sont souvent les moins transparents, tandis que les modèles plus simples et interprétables peuvent sacrifier une partie de leur précision. Trouver le juste équilibre entre ces deux aspects est un défi majeur pour les chercheurs et les praticiens de l’IA.

La recherche se poursuit activement pour développer de nouvelles méthodes d’explicabilité plus performantes. Des approches prometteuses émergent, combinant des techniques d’apprentissage automatique avancées avec des concepts issus des sciences cognitives et de la psychologie. L’objectif est de créer des explications non seulement précises techniquement, mais aussi intuitivement compréhensibles pour les utilisateurs humains.

L’avenir de l’IA explicable s’oriente vers une approche plus holistique, intégrant l’explicabilité dès la conception des systèmes d’IA. Nous envisageons des architectures hybrides combinant des composants explicables et des modules plus opaques, offrant effectivement un compromis optimal entre performance et transparence.

Au final, l’IA explicable représente un domaine de recherche et d’innovation crucial pour l’avenir de l’intelligence artificielle. Elle est essentielle pour surmonter les défis posés par l’IA boîte noire et pour construire des systèmes d’IA dignes de confiance, éthiques et conformes aux réglementations émergentes. Bien que des obstacles subsistent, les progrès continus dans ce domaine ouvrent la voie à une IA plus transparente, responsable et alignée sur les valeurs humaines.

Un commentaire

Les commentaires sont fermés.